SEO меняется, и это хорошо

SEO меняется, хотя еще недавно нам казалось, что это не так. Ну, а некоторые до сих пор продолжают верить в то, что никаких изменений не происходит. Им я советую пройти мимо этой статьи — ребята, все спокойно, все хорошо, дышите ровнее, это просто статья. Для других же, кто хочет идти в ногу со временем, хочу сказать следующее: SEO изменяется, и будет меняться дальше. Эпоха ссылочного ранжирования, очевидно, уходит. Это не значит, что ссылки не будут учитываться поисковиками (в том или ином виде будут — даже в «бессылочном» алгоритме Яндекса), но они никогда больше не будут единственным драйвером роста в поисковом маркетинге, волшебной педалью, нажав на которую можно будет влететь в топ Яндекса и Google. И лично у меня не вызывает никаких сомнений: если вы хотите продолжать получать трафик из «органики», то нужно меняться. Меняться самим, менять принципы и подходы к продвижению сайтов.

SEO никогда не было чем-то статичным. Менялась роль различных факторов ранжирования, количество этих факторов росло, и будет расти в дальнейшем. Мы верим, что наступают времена, когда SEO перестает быть просто реинжинирингом поисковых систем (уделом инженеров-отщепенцев, как недавно сказал Дмитрий Шахов в своем интервью), а становится частью общего классического маркетинга.

Но SEO, очевидно, становится более сложным. И на это есть несколько причин. Поисковики стараются идти по пути удовлетворения потребностей пользователя (а не только нахождения релевантных ответов), это действительно так, мы все наблюдаем в последнее время этот тренд. С другой стороны, на многие факторы становится влиять все сложнее — фактически, влияние на них - это и есть выполнение той самой заповеди, данной нам Платоном: «Продолжайте развивать и наполнять ваш сайт уникальной и полезной информацией и т.д.». Аминь.

Не все изменения, которые вы найдете в этой статье, однозначно помогут вам здесь и сейчас улучшить ваши позиции в поисковых системах. Некоторые из рекомендаций, которые приводятся, выведены на основании нашего собственного опыта. Другие — это следствие, скорее, логических умозаключений и являются своего рода ударом на опережение.

Ну и, наконец, самое главное. Помните, что SEO всегда было и являлось не тайным знанием особо просветленных. Знать — недостаточно. SEO — это рутинная работа, в которой важны любые мелочи. И скрупулезная работа над мелочами отличает хороших сеошников от всех остальных. Рефрешить статсы во время апов — большого ума не надо.

Итак, поехали.

Тренд №1: Mobile важнее, чем когда-либо прежде — в том числе для SEO

У вас не должно больше быть никаких оправданий для себя: не иметь мобильную версию сайта или адаптивный дизайн в 2014 году — это недопустимо!

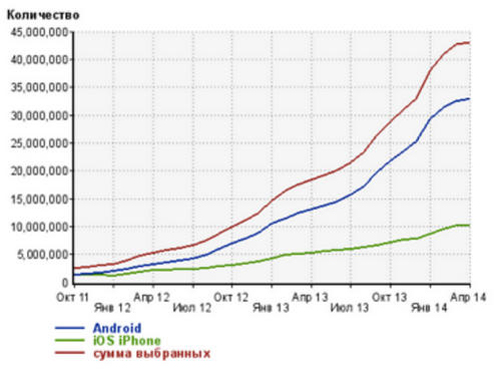

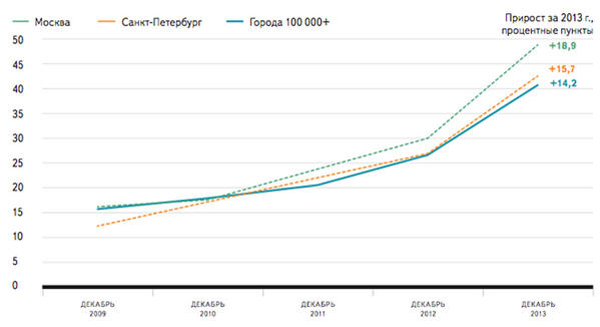

Вот так вот растет количество переходов на сайты рунета только с двух операционок - Android и iOS iPhone по данным Liveinternet.ru. И это, не считая Windows Phone и Symbian OS. По данным последнего информационного бюллетеня Яндекса, доля мобильного трафика в Москве выросла на 64% за последний год. В среднем, в городах с населением более 100 тыс. человек, проникновение мобильного интернета уже достигло показателя 40%:

В связи с этим возникает вопрос: мобильная версия или адаптивный дизайн? Тут не все так просто на самом деле, но мы все-таки в итоге остановились на адаптивном дизайне. Не буду расписывать все преимущества адаптивного дизайна, по сравнению с мобильной версией с точки зрения SEO, но обозначу один: одна страница — один url (не нужен rel=cannonical).

Минусы у адаптивного дизайна тоже есть: более высокая цена по сравнению с мобильной версией. Чем более сложная структура у сайта, тем, как правило, дороже обходится разработка адаптивного дизайна. Решайте сами, но оставлять этот вопрос в подвешенном состоянии уже неправильно.

Почему мы считаем, что мобильная версия или адаптивный дизайн важны для SEO? Тому есть несколько причин. Выдача на мобильных устройствах и на десктопах отличается в Google. Мобильная выдача в Google более привязана к пользовательской локации, чем стационарная. Вероятно, ранжирование также учитывает, есть ли мобильная версия сайта или нет (это не утверждение, а просто логическое умозаключение).

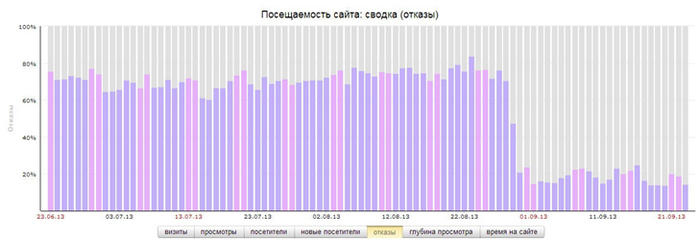

Вторая причина. Учитывая достаточно большое количество переходов с мобильных устройств, переходы с них все больше начинают влиять на показатель «отказы». Ниже на скриншоте представлены данные из Яндекс-Метрики по нашему собственному сайту. Редизайн и адаптивная верстка позволили нам уменьшить кол-во отказов примерно с 78% до 18%. Продолжая работать над этим показателем и в текущем году, нам удалось снизить показатель отказов (при общем росте трафика) до 14%, таковы показатели за последний квартал.

Тренд №2. Контента не бывает много

Поисковые системы любят контент, как никогда прежде. И если вы хотите увеличить количество страниц в индексе, то нужно создавать много контента. Но при этом отдавать себе отчет в том, что сам по себе контент никакой ценности не имеет, а представляет ценность только, извините за тавтологию, ценный контент.

Я крайне рекомендую вам начать мониторить, какой процент страниц вашего сайта попадает в так называемый дополнительный индекс Google (Supplemental Index). Если Яндекс выкидывает из индексной базы страницы, которые он считает некачественными, то Google добавляет такие страницы в дополнительный индекс. Страницы в основном индексе проверяются оператором«site:вашсайт/&». Как рассчитать процент страниц в дополнительном индексе? Приведу пример на нашем сайте.

Оператором «site:texterra.ru» мы получаем информацию, что Google знает 1110 страниц на проверяемом домене. Оператором «site:texterra.ru/&» мы можем посмотреть, что 713 страниц находятся в основном индексе. Несложно посчитать, что, если 1110 проиндексированных страниц — это 100 % нашего сайта, то 713 страниц — это 64,23 % страниц. Следовательно, 35,77 % страниц сайта находится в Supplemental Index (или, попросту, в «соплях», на языке оптимизаторов).

Все популярные «движки», как правило, создают большое количество дублей страниц, малоинформативных страниц, страниц пагинации и т.д. — по этой причине на крупных сайтах (например, интернет-магазинах с большим количеством категорий товаров) количество страниц, которые попадают в основной индекс, часто не более 30 %. Старайтесь, чтобы и ваши показатели были не ниже данного значения. Для сайтов b2b этот показатель должен быть не менее 35-40 %. Если количество страниц в основном индексе более 60 % — это хороший показатель, вам есть чем гордиться.

При этом надо понимать одну вещь: попадание в дополнительный индекс — это не приговор. Страницы могут переходить из дополнительного индекса в основной, при условии, что эти страницы получают хорошие поведенческие.

Для того, чтобы процент страниц в основном индексе был высокий, нужно делать очень простые вещи: создавать и публиковать на сайте качественный, востребованный аудиторией контент. Только определять этот показатель нужно не по своему субъективному мнению, а по таким показателям в системах статистики, как длина сессии, количество просмотренных страниц на посетителя, процент «отказов» и т.д. В среде «матерых» оптимизаторов есть какое-то снобистско-пренебрежительное отношение к такому инструменту, как Вебвизор, а зря. Используйте Вебвизор, откроете для себя много интересного о том, как пользователи взаимодействуют со страницами вашего сайта.

Обычно высокие поведенческие метрики можно найти в блогах. А это значит — пора, наконец-то, начать вести блог. Если вы развиваете интернет-магазин, то в блоге можно публиковать сравнительные обзоры продукции. Если вы продаете услуги, то вы можете через свой блог демонстрировать вашу экспертизу. Если вы занимаетесь развитием корпоративного сайта, то блог вам поможет обозревать последние новости вашей тематики и вашего рынка. Авторская позиция, личное высказывание, неофициальный тон — то, что отличает обычно блог от официального сайта. Мы думаем, что время корпоративного блоггинга только-только наступает.

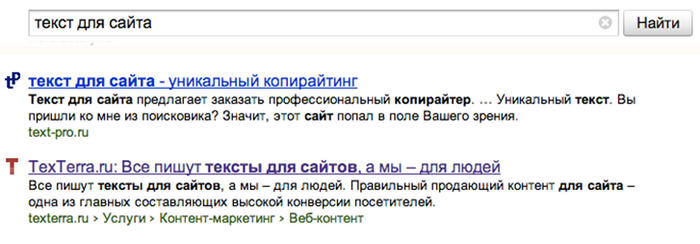

Тренд №3. Работа над улучшением CTR в естественной выдаче

Очевидно, кликовые поведенческие факторы достаточно важны для ранжирования. В общем-то, это не является такой уж большой тайной. Но в реальности очень мало людей уделяют этому должное внимание. CTR в органике позволяет мониторить панель вебмастера Google (Google Webmaster Tool). Понятно, что там вы найдете данные только для Google, но корреляция с Яндексом, на наш взгляд, там достаточно высокая. Понятно, что CTR в естественной выдаче напрямую зависит от сниппета. Просмотрев данные в панели вебмастера Google, можно найти поисковые фразы с низким CTR. Релевантные страницы для этих запросов следует переработать.

Не забывайте, что к формированию Title нужно подходить творчески. Ваша задача — не только сохранить текстовую релевантность заголовка браузера, но сделать его более привлекательным, зазывным, креативным. Другими словами, он должен выделяться на фоне других заголовков на странице выдачи.

На описание в сниппете влиять гораздо сложнее, но тоже можно. Трудность состоит в том, что эта часть сниппета — запросозависима (Title на самом деле тоже, но описание значительно чаще меняется в зависимости от запроса) и формируется под каждый запрос в отдельности: поиск учитывает и подставляет в выдачу наиболее релевантный вводимому запросу кусок текста. Вы, скорее всего, не сможете улучшить описание сниппета под все запросы, по которым ранжируется страница. Но этого и не требуется: оптимизируйте этот текст под осиновые поисковые запросы, по которым получаете трафик. Мы поступаем обычно следующим образом. Если описание сниппета нас не удовлетворяет, переписываем эту часть текста на странице. Иногда поиск перестает подставлять нужную нам текстовку, а находит более релевантный запросу кусок текста вообще в другой части страницы. Но проделав эту операцию несколько раз, можно добиться нужного результата.

Для ранжирования внутри ТОП-10 оптимизация сниппетов просто необходима.

Тренд №4. Авторизация текстов в Google

Не буду ссылаться на исследования (а таковых много) и скажу, что юзерпик автора в серпе влияет положительно на CTR документа. Нас интересует другой момент. Чуть более месяца назад, Мэтт Каттс на конференции Search Marketing Expo подтвердил, что Google использует Author Rank, особенно это касается так называемых In-depth articles. Все началось даже чуть ранее этой конференции, один из пользователей Twitter опубликовал такую запись со ссылкой на Амита Сингхала, руководителя отдела ранжирования Google: Вольный перевод: Author Rank все еще не используется, возможно, будет использоваться в будущем.

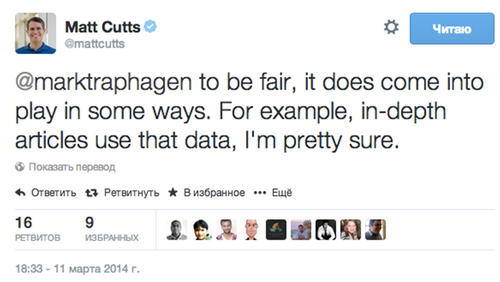

На этот твит и отреагировал Мэтт Каттс:

Вольный перевод: Говоря по справедливости, он (имеется в виду Author Rank - примечание Д.С.) уже в некотором роде участвует в игре. Например, in-depth article использует эти данные, я уверен в этом.

И несколькими днями позже на конференции Мэтт еще раз подтвердил эти данные. О чем, собственно, идет речь? Речь идет об алгоритме определения авторитетности отдельного автора. Мы предполагаем, что ранжирование в Google все больше и больше будет учитывать подтвержденное авторство материала. Соответственно, материалы более авторитетных авторов, являющихся экспертами в своей области, будут ранжироваться выше, при прочих равных показателях. Особенно это касается информационных статей.

Соответственно, «качать» свой авторский профиль нужно начинать уже сейчас. Мало того, мы предполагаем, что движение в сторону ранжирования информационных запросов на основании авторства статьи в той или иной степени будет осуществляться и в Яндексе. У Яндекса есть профессиональная соцсеть «Мой Круг», почему бы ее не начать использовать для верификации информационных статей? Объективных причин для этого нет. И нам кажется, развитие такого сценария вполне вероятно.

Изменение №5. Социальные сигналы

Прямое влияние социальных сигналов на ранжирование в органическом поиске на текущий момент времени отрицается как Яндексом, так и Google. Но, черт возьми, оно подтверждается практикой:) Мы наблюдаем это не по одному, и даже не по десятку проектов — корреляция между соцсигналами и ранжированием в «органике» есть. Причем, мы даже можем выделить самый сильный сигнал — это не лайки, не расшаривания, а именно переходы из соцсетей. Но переходы не накрученные, а реальные — переходы, что называется, «живых» пользователей. Возможно, влияние не прямое, а опосредованное — через те же ПФ. Но вот запускаешь контекст — особого влияния на органический трафик не наблюдается. Начинаешь работать с соцсетями, откуда пошел трафик, — и начался рост трафика из органики. Ну, отрицают поисковики прямое влияение — пусть отрицают, нам же с вами результат надо делать, верно?

Что мы тут можем порекомендовать. Собственные группы и паблики — просто mast have. Да, я уже предвижу ваши возражения: не для всех же тематик можно сделать группу или паблик. Ну, а вы попробуйте сначала, а потом говорите. Нам это удалось сделать для интернет-магазинов одежды (работает очень хорошо), для b2b услуг (работает), для ветеринарной клиники (тоже работает), для автосервиса (трафика меньше можно получить, но корреляция с поисковым трафиком есть даже на небольших объемах трафика из соцсетей). Да, бесспорно, есть тематики, в которых группы или паблики не могут собрать аудиторию (ну, классическим примером тут будет тематика пластиковых окон), но для большого количества ниш эта тема — абсолютно рабочая. Второй момент, который интересует обычно всех, это бюджетирование этих работ. Мы создаем контент для сайтов, которые берем на продвижение, и зачастую это уже половина успеха для привлечения трафика из соцсетей. Дополнительного контента создаем немного, либо не создаем вообще — просто промотируем в своих группах информационные статьи. Соответственно, дополнительного бюджетирования практически не требуется — работа по созданию контента уже заложена в стоимость услуг по продвижению.

Что важно еще. Не нужно зацикливаться только на Facebook и «ВКонтакте». Трафик можно получать из Twitter, из Pinterest, tumblr.com тоже набирает все большую популярность. Если можете поставить на поток создание презентаций, то добро пожаловать на Slideshare.net. Если чувствуете в себе силы создать тематический видеоподкаст —соответственно, идем на YouTube.com. Тут главное — привлечь именно трафик на свой сайт из этих каналов — целевой и качественный. Спустя 2-3 недели увидите, как начнет расти трафик из органики.

Тренд №6. Коммерческие факторы ранжирования

Трудно не согласиться с этим тезисом: коммерческие факторы ранжирования меняют традиционное SEO.

Не буду много уделять внимания данной группе факторов ранжирования — не потому что они не важны, а потому, что это отдельная и довольно-таки большая тема. Коротко скажем: коммерческие факторы — это те факторы, которые работают на улучшение доверия к сайту со стороны пользователей. Это факторы, связанные с представлением цен на сайте, с подтверждением вашей экспертизы в теме (отзывы и сертификаты), факторы, связанные с полнотой представления контактных данных. Сюда же я бы отнес такие факторы, как количество возвратов на сайт, количество прямого type-in-трафика, количество переходов по брендированным запросам и т.д. Обо всем этом достаточно много информации в рунете, о важности коммерческих факторов в последнее время много пишут и говорят (Людкевич, Севальнев, Камская и т.д).

Важно: Работа по улучшению коммерческих факторов ранжирования предполагает более глубокое погружение оптимизатора в бизнес клиента. И трудности здесь есть — говорю это на основании нашего собственного опыта. За последние годы, к сожалению, выработалась некая парадигма взаимоотношений заказчиков SEO услуг и исполнителей, предполагающая невысокую степень вовлеченности. Эта парадигма будет меняться, она уже меняется. Но процесс только начался. А как он закончится – зависит, в том числе, и от нас с вами.

searchengines.ru